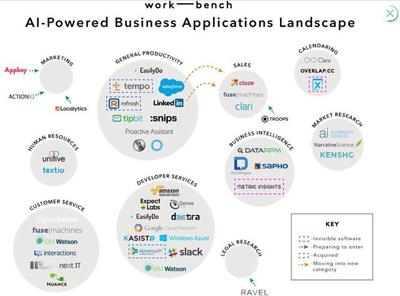

人工智能技術以前所未有的速度發展,已深度融入醫療、金融、交通、教育等關鍵領域。隨著AI應用軟件開發的快速推進,安全問題日益凸顯,成為制約人工智能健康發展的關鍵因素。

在AI應用開發過程中,數據安全始終是首要考量。訓練數據的質量與安全性直接影響模型性能,若數據存在偏見或遭受污染,將導致決策偏差,在醫療診斷、信貸審批等場景可能造成嚴重后果。開發者必須建立嚴格的數據治理體系,確保數據采集、標注、存儲全流程安全可控。

算法安全同樣不容忽視。對抗性攻擊可能通過微小擾動欺騙AI系統,自動駕駛中的交通標志識別、人臉認證系統都曾因此暴露出安全隱患。開發團隊需要將安全測試貫穿整個開發生命周期,采用對抗訓練、形式化驗證等方法提升模型魯棒性。

隱私保護是AI應用必須跨越的另一道門檻。聯邦學習、差分隱私等技術創新讓用戶數據"可用不可見"正在成為行業標準。開發者在設計架構時,就應將隱私保護作為核心要素,而非事后補救。

AI系統的透明度和可解釋性也關系到應用安全。在關鍵決策場景,黑箱模型可能帶來不可預知的風險。通過開發可解釋AI技術,建立算法審計機制,才能增強用戶信任,促進負責任的人工智能發展。

人工智能的安全發展需要多方協同:技術團隊需將安全理念融入開發基因,行業組織應加快安全標準制定,監管機構要完善法律法規。只有在安全基石上構建的人工智能應用,才能真正賦能各行各業,推動社會進步。